引言

安全性问题是煤矿作业过程中的一大关键性问题,必须予以高度重视。煤矿井下条件极为恶劣,工况十分复杂,存在着一系列安全事故危险因素,一旦发生安全生产事故,将会给煤矿生产的正常进行造成极大的负面影响。煤矿用移动机器人可以对危险的井下环境进行检测,并开展人员救援工作,对煤矿用移动机器人进行深入分析研究具有重要意义。有关煤矿井下移动机器人研究所面临的一大难题就是如何确保在复杂的井下作业环境下,移动机器人具备较强的路径规划性能。文中主要利用强化学习算法中的Q-learning算法,对煤矿井下不确定环境下的移动机器人路径规划进行分析和探讨。

1.基于Q-learning算法的移动机器人路径规划

1.1 Q-learning算法

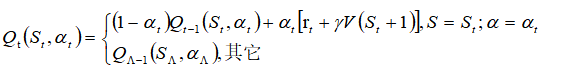

Q-learning算法属于强化学习方法范畴,所谓强化学习又叫增强学习,通过自环境状态向动作映射的学习来获取最大的累积回报值,强化学习被广泛应用于智能控制、分析预测以及机器人等领域。在不知道初始条件的前提下确定相关策略是Q-learning算法的主要任务。在Q-learning算法中,不必对环境模型予以过多考虑,仅仅是选择能够进行迭代计算的Q函数加以直接优化即可,而这个Q函数则能够在相应的环境状态St之下,执行动作αt,用公式可以将Q-learning算法表述如下:

![]() (1)

(1)

作为调度算法仿真的输入模块,其主要的作用为产生数据包,并且对频带宽度进行设置。在此次的试验仿真过程之中,为了达到不同条件下的各种算法的实际效果,需要配置更多的队列数据包,并且使得不同队列之中存在着足够的差异性,而为了通信的便利性,则需要将频带宽度设置为基于LTE的10 MHz带宽。基于业务队列自身的特性,需要对其到达速率、队列的最大长度、内部用户的信道等相关数据进行涵盖。

对于Q-learning算法的引入,主要是在实际的环境数据受限,而且基本上传输的数据都是实时数据的前提之下,观察算法如何能够高效地对数据进行处理,并且及时地发布指令,合理地绘制队列到达速率以及频带的宽度,以此达到系统负荷较重的仿真条件。

1.2 基于Q-learning算法的路径规划

基于Q-learning算法的路径规划方法的优势在于,其能够在对初始环境了解不足的条件下,通过算法优化,使得机器人能够在面临位置环境时,始终在最短时间内做出最优的路径选择。基于此,环境数据并不是基于Q-learning算法的路径规划的前提条件,而是机器人到了工作环境主动去获取的,这就使得环境数据能够始终与实际工作环境一致,而无需为了更新初始环境数据而支出更多的成本。机器人根据自身配备的一系列传感器,能够在工作环境中获取自身工作所需要的一切环境数据,根据数据对于安全的路径进行确定。

据此,基于Q-learning算法的井下机器人路径规划需要经过下述几个步骤:

(1)由机器人自带的传感器了解当前井下工作环境;

(2)将环境数据传递至芯片,并且由芯片确定一个选定动作并执行;

(3)对下一个环境的基本数据进行测量并且传递到芯片;

(4)机器人收到来自于芯片的强化信号;

(5) 依据下式对Q值进行调整:

(2)

(2)

在上式中,

诚如上文所述,基于Q-learning算法,能够利用机器人自带的传感器对井下复杂工作环境进行测量和识别,然后由芯片判断机器人与障碍物之间的距离,从而据此确定机器人的移动路径。在这种算法之下,机器人即使是碰到了障碍物也不会返回到原点,而是会就地寻找新的路径,这样也能够起到提高路径规划效率的作用。在Q-learning算法之下,机器人如果最终寻找到了目标点或者达到了预定的最大步数,第一个学习周期即告结束,然后接着进入到下一个阶段的学习过程,并且循环重复。

2.仿真实验分析

2.1基于Q-learning算法的路径规划仿真实验

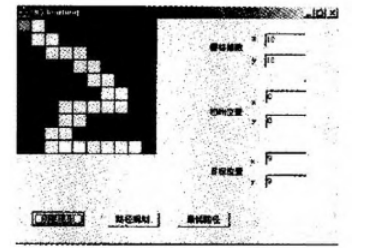

有关基于Q-learning算法的移动机器人仿真实验,可以先设置参数,一般以最初所在位置为起点,在不与任何障碍物发生碰撞的前提下,用尽量少的步数达到出现事故的位置,是井下移动机器人的主要任务。井下环境仿真场景详情如图1所示。

图1 井下环境仿真场景

根据图1中的基本情况,对于井下机器人基于Q-learning算法进行路径规划,首先就是学习一定的障碍物,设置好参数;其二则是要以最小的步数,最短的时间到达目的地。基于此,我们认为,机器人的学习以及信号强化,主要包括了如下2个方面的内容:

(1)Rs={-10,10,-100,0},对应的环境条件为靠近障碍物、与障碍物有一定距离,与障碍物碰撞、其它。

(2)Rg={100,0},对应的结果为,到达目的地以及寻找目的地。

在机器人移动的过程中,会通过传感器不断地接受环境数据,并且通过芯片对这些数据进行强化,然后对强化信号的加权值进行判定,并且确定机器人移动与障碍物之间的关系,即是否存在障碍物,与障碍物的距离是否发生变化,发生何等变化等等。通过这样的判断,能够帮助机器人提升路径规划能力。

2.2仿真结果分析

在上文规定的仿真环境之下进行仿真,机器人的仿真结果如图2所示:

图2 路径规划仿真结果

如图2所示,井下机器人基于Q-learning算法的路径规划是非常成功的,整个过程基本上没有任何的多余步骤,也确保了机器人不与障碍物接触。再回过头来看,如果机器人从初始位置开始学习,则成功到达目的地的步数越少,则行动策略的优化越成功,此次实验中的机器人成功的步数情况如图3所示

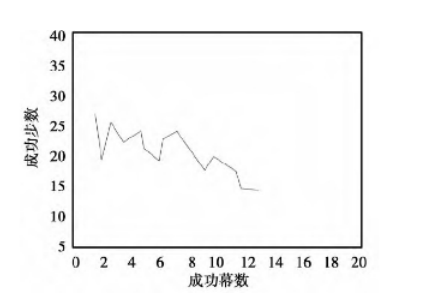

图3 基于Q-learning算法的成功幕数收敛曲线图

如图3所示,机器人在不断学习的过程中,对于井下环境越来越适应,这也有助于提升机器人的行为决策效率,而且随着学习的进行,机器人成功到达目的地的步数越来越少,并且逐渐收敛,最终固定在一个稳定的步数。这就说明,基于Q-learning算法的机器人路径规划方法能够确保机器人在一个固定环境中,通过自身的学习,寻求到最优化的路径,从而实现以最小步数到达目的地。这意味着基于Q-learning算法的井下机器人移动的路径规划效率也能够得到有效的保障。

3. 结论

综上所述,安全性问题是煤矿井下作业过程中必须予以高度重视的关键性问题。煤矿用移动机器人能够胜任井下环境检测及被困人员救援等任务,深入分析煤矿用移动机器人具有重要的现实意义,当前该领域所面临的一大难点问题就是移动机器人的路径规划问题。Q-learning算法具有实时性以及自适应性优势可以解决在煤矿井下环境不明的情况下的机器人移动问题,从而使机器人在最短时间内作出最佳救援路径选择。仿真实验结果证实了此种算法的优越的路径规划能力。我们的下一步工作就是要结合煤矿安全救援的实际情况,进一步提高机器人的学习效率以及收敛速度,并且推动该算法在实践之中的应用。

参考文献

[1] 张泽明,罗文坚,王煦法.基于免疫进化非选择机制的移动机器人路径规划算法研究[J].电子与信息学报,2007(08):1987-1991.

[2] 蔡自兴,贺汉根,陈虹.未知环境中移动机器人导航控制研究的若干问题[J].控制与决策,2002(04):385-390+464.DOI:10.13195/j.cd.2002.04.1.caizx.001.

[3] 李擎,徐银梅,张德政,尹怡欣.基于粒子群算法的移动机器人全局路径规划策略[J].北京科技大学学报,2010,32(03):397-402.DOI:10.13374/j.issn1001-053x.2010.03.024.

[4] 戴博,肖晓明,蔡自兴.移动机器人路径规划技术的研究现状与展望[J].控制工程,2005(03):198-202.

[5] 刘春阳,程亿强,柳长安.基于改进势场法的移动机器人避障路径规划[J].东南大学学报(自然科学版),2009,39(S1):116-120.

作者简介:秦永杰 (2000-)男,陕西渭南人, 汉族,大学本科,现任陕西陕煤黄陵矿业公司一号煤矿信息部实习大学生。