1.引言

随着无人机的广泛应用,其智能化和自主化决策成为重要课题。无人机作战环境常常充满了不确定性和变化,然而越来越多的任务需要无人机系统在不同环境和情境下做出智能化和自主化的决策。因此,现有决策系统面临复杂性和适应性等问题。基于深度强化学习的决策优化方法具有广泛的应用潜力。目前,民用领域如自动驾驶、物流管理和游戏等,DRL算法已经展现出了决策优势。尤其是游戏领域,它能够在复杂和变化多端的游戏环境中更好地完成任务。军事博弈与游戏博弈有着高度相似性[1],为深度强化学习在军事决策领域方向的研究提供了思路,为未来智能化无人化军事作战样式带来巨大的机会和挑战。从美国最新发布的《2018年国防部人工智能战略概要》和《2019年美国空军人工智能战略》可以看出,美国国防领域未来近20年将重点投资发展无人系统和人工智能技术,在未来战场使用先进的系统和人工智能将成为趋势之一[2]。因此,无人作战决策的研究十分必要。

文中将以无人作战决策的任务分配与路径规划作为主要内容,重点分析了人工智能技术之一的深度强化学习在多无人机路径规划与任务分配的研究,提出了将DRL的最新算法近端策略优化应用于无人机作战决策的路径规划与任务分配的思路并给出决策流程。

2. 深度强化学习

2.1 深度强化学习发展

近年来,强化学习(Reinforcement Learning, RL)因其强大的探索能力和自主学习能力,已经与监督学习(supervised learning)、无监督学习(unsupervised learning)并称为三大机器学习技术[3]。强化学习的目标是学习一个行为策略,使得智能体选择的动作能够获得环境最大的奖赏。随着处理问题复杂度的提升,强化学习面临处理高维非结构数据、连续状态空间和动作空间等挑战。该挑战阻碍了强化学习的发展。

2013年,深度强化学习(deep reinforcement learning)由谷歌的DeepMind提出,并在《自然》杂志发表了Human-level control through deep reinforcement learning的论文。深度强化学习结合了深度学习的感知能力与强化学习的决策能力,利用深度神经网络的特征表示能力对强化学习的状态、动作、价值等函数进行拟合。2015年,Mnith等人采用DRL的算法之一DQN(Deep Q Network)对Atari的2600款游戏进行测试。其通过卷积神经网络处理图像输入,根据不同的游戏制定不同的回报方式,通过深度强化学习算法学习该游戏的控制策略。结果表明深度强化学习模型的游戏水准远远超出人类玩家[4]。2017年,Ahmad等提出实现基于深度强化学习的汽车车道保持方案。Hyunmin等提出通过深度强化学习算法实现汽车的自动刹车功能,并经过七万次的学习和迭代后,汽车成功的学会了自动刹车。2018年,美国国防部发布的《人工智能战略概述》("Summary of the Department of Defense Artificial Intelligence Strategy")中提到了深度强化学习。该报告指出,深度强化学习等新兴技术可以用于开发自主系统,从而实现更高效、更安全、更节约资源的军事操作。报告还强调了加强军方对于人工智能和自主系统研发的投资和努力,以推动美国在军事应用方面的创新和领导地位。

随着深度强化学习在各个领域相继取得突破,其技术在基本原理、探索方式、样本管理与梯度计算等方面也不断发展。深度强化学习算法按照其神经网络的输出数据类型分为值函数网络和策略网络两种类型。深度Q网络(Deep Q-Network,DQN)、深度确定性策略梯度(Deep Deterministic Policy Gradient,DDPG)和异步优势动作评价算法(Asynchronous Advantage Actor-Critic,A3C)作为三种经典DRL算法,开创性地将传统强化学习理论与深度学习相结合。其中基于值函数网络的深度强化学习算法主要为DQN与DQN改进系列,主要用于处理离散动作空间下的决策问题。基于策略网络的深度强化学习算法主要是以Actor-Critic框架为基础的DDPG、A3C等,用于处理高维连续动作空间下的决策问题。三种经典算法中,DQN与DDPG属于off-policy算法,利用了贝尔曼公式特性更新Q网络,普遍存在过估计的问题,同时off-policy算法基于单步转移样本学习,目标值的计算不是无偏的。因此,影响了训练的稳定性。相比于DQN与DDPG采用经验回放重复利用历史数据提高采样效率,A3C采用了多环境并行采样提高采样效率。因此,A3C低下的样本效率使其在采样成本较高的任务中几乎不具备使用价值。若多次利用同一批在线采样的样本,会导致单一梯度方向上过大的参数更新而破坏训练稳定性[5]。经研究人员对DRL的不断优化,诞生了许多新的SOTA(State of the Art,当前最佳)算法。TD3、SAC和PPO作为其中的杰出代表,除了在学术界得到广泛认可,在落地实践中也被证实具有良好的实用价值,同时三者作为一个整体在功能上覆盖了各种不同的任务类型[5]。

2.2 基于深度强化学习的无人机作战决策

深度强化学习算法解决了传统算法和智能算法高维非线性、局部最优、先验知识依赖的问题。同时战场环境的不确定性、复杂性和动态性,使得解空间庞大,使用有效规则和启发式方法效率低下,将深度强化学习算法应用到无人作战决策的任务分配与路径规划研究中,一方面结合了深度学习在图像识别和分类领域中的优势,解决了基于计算机内存和算法处理能力的局限,由于无人机应用领域高维连续空间特点无法遍历所有状态-动作对的问题。另一方面结合了强化学习处理智能体的序列决策问题的优势,通过智能体通过与环境不断交互,根据反馈信息迭代更新决策方式。

目前,无人作战决策在任务分配方面的文献较少,大多采用多智能体深度确定性策略梯度(Multi-Agent Deep Deterministic Policy Gradient,简称MADDPG)算法,一种基于DDPG改进的多智能体算法。文献[10]基于上述算法,结合多无人机任务分配问题,从网络结构、状态空间、动作空间和奖励函数设计了模型结构。同样,无人机集群在作战决策的协同路径规划方向采用的DRL算法大多是MADDPG(Multi-agent Deep Deterministic Policy Gradient)。文献[6]和文献[7]中采用的均是MADDPG,特点为集中式训练,分布式执行。其中文献[6]针对大规模的情况,还提出了分布式MADDPG算法。一个合理的回报函数可以帮助智能体很快明确学习方向,反之可能会使算法的迭代陷入局部最优或无法收敛。文献[4]采用稀疏奖励和系数变化奖励分段综合的方式设计回报函数,实现无人机自主路径规划功能,综合考虑无人机飞行时高度以及碰撞因素、低空飞行的限制因素、障碍物距离的计算系等。文献[8]为提高了完成任务的效率和训练时间,利用搜救的先验知识进行奖励重塑的方式设计回报函数。文献[6]是多无人机协同路径规划,相比于文献[4]与文献[8]单架无人机路径规划的回报函数设计需要考虑的因素更多,设计起来更加复杂。设计的奖励函数主要包含了两部分,一部分为碰撞惩罚来避免无人机之间发生碰撞,另一部分为目标奖励,由优化指标与目标点约束组成。优秀的状态空间信息所带来的性能提升效应显著高于算法组件改进、超参数调整等方法。文献[8]多无人机协同路径规划中智能体的状态空间组成部分主要包括自身状态、目标点状态、其他智能体状态几个部分,每个状态下使用的都是关键信息,没有多余的次要细节。

3. 基于近似策略优化的决策方法

3.1近似策略优化原理

PPO(Proximal Policy Optimization,近端策略优化)作为Actor-Critic框架下的代表算法,借鉴了基于策略的估计思想,优化了步长选择机制,能够很好地应用于包含高维的状态空间和连续和离散的动作空间的路径规划问题[11]。

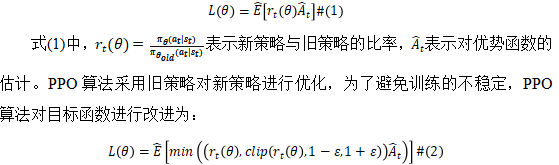

近端策略优化,顾名思义,该算法保证更新后的策略不会跨越一个较大的阈值。PPO算法采用一种“替代”目标:

式(2)中,表示对策略的比率进行修剪,使其处于[1-ε,1+ε]。修剪使得新策略不会发生太大的变化,从而使算法稳定。在提高稳定性方面,PPO算法还使用了一个重要性采样比率的约束来限制策略更新的范围,以避免策略更新过大,产生不稳定的结果。此外,PPO还利用了多个策略版本来提高策略的鲁棒性和可靠性,从而更好地控制策略的更新。

DDPG算法在训练过程中容易出现过拟合的问题,而过拟合可能导致策略过度依赖训练数据,使得在未知环境下的性能表现不佳。PPO算法通过引入剪枝技术和策略重用技术来防止过拟合。该技术通过计算神经网络中各个权重对应的重要性,然后将重要性较低的权重进行剪枝,以减少神经网络的参数数量,从而降低模型的复杂度和计算资源的需求。

PPO算法在解决深度强化学习中的稳定性问题方面表现出很好的效果,并且在一些强化学习任务上取得了比其他算法更好的性能。同时,PPO算法也具有较好的通用性,可以适用于各种不同的强化学习任务和环境。在MuJoCo、Atari2600以及3D环境中,PPO算法能够取得比A2C算法和A3C算法更好的表现[12]。

3.2 方法框架

基于深度强化学习的方法框架如下:对无人机作战环境进行建模,然后选择合适的深度强化学习算法,接着设计深度神经网络结构,用于近似值函数或策略函数。在训练过程,通过与环境的交互,收集无人机在不同状态下的行动和奖励信息,构建训练数据集,不断优化网络参数,使其能够准确预测状态价值或生成最优策略。通过训练好的模型做出决策以达到预定的目标。方法框架如图1所示。 图1 深度强化学习流程框架

图1 深度强化学习流程框架

首先,需要根据无人机作战决策的任务给出任务描述、任务分析、各子模型描述,提出作战决策问题的任务需求约束及综合规划;形式化描述实验中常用性和有效性指标以及具体决策场景下的相关指标。

然后,对无人机作战环境进行建模。这一步骤至关重要,因为它决定了后续深度强化学习模型的性能。我们将无人机作战环境抽象为一个状态、动作和奖励函数的集合。状态表示了环境的当前情况,包括无人机位置、目标位置、敌方单位位置等信息。动作是无人机可以采取的行动,如移动、攻击、躲避等。奖励函数用于评估无人机的每一步行动,以确定其对任务目标的贡献。

接下来,根据需求选择合适的算法。常见的深度强化学习算法有DQN、DDPG和PPO等。DQN和DDPG是Off-Policy算法,PPO是On-Policy算法,On-Policy方法在收敛性和稳定性方面相对较好,适用于需要较快收敛和较高稳定性的任务。而且On-Policy算法,数据是以episode形式进行采集和运算的,天然支持循环神经网路RNN。DQN只适用于可穷举的离散动作空间,DDPG支持连续动作空间,若任务需要离散空间还需要将连续动作空间离散化,而PPO可用于离散动作空间也可用于连续动作空间,建议选用PPO算法。

在设计深度神经网络结构时,选择使用值函数近似和策略函数近似的方法。值函数近似的目标是准确地预测每个状态的价值,以便在每个状态下选择最优的动作。策略函数近似的目标是生成最优的动作策略,以最大化累积奖励。网络结构的设计需要根据具体问题来确定,通常包括多层神经网络、卷积神经网络(CNN)或循环神经网络(RNN)等结构。

通过与模型环境的交互来收集训练数据。在每一次交互中,无人机将根据当前状态选择一个动作,并根据奖励函数获得一个奖励信号。这些信息将被用来构建训练数据集,其中包括了无人机在不同状态下的行动和奖励信息。这个数据集将用于训练深度神经网络模型。通过训练过程,不断优化网络参数,使其能够准确地预测状态价值或生成最优策略。在训练过程中,模型将根据收集到的奖励信号来调整自己的行为,逐渐提高性能。

最后,通过训练与业务指标判断训练好的模型是否可以达到预定的目标。无人机可以根据模型生成的策略来执行任务,自主地应对各种情况,以最大程度地提高任务成功的机会。

5. 结论

本研究基于深度强化学习提出了一种无人机作战决策优化方法。该方法能够处理决策的复杂性,实现协同合作,并具备学习适应能力。根据对深度强化学习在无人集群协同任务分配和路径规划的运用和研究进行的详细的论述,分析了在无人作战决策领域使用近似策略优化算法相比于其它算法的优势,使无人集群面对复杂不确定环境时可以自动调整行为适应快速动态变化的战场环境,具备一定的决策能力。未来在仿真推演上可以扩大集群规模、复杂化任务需求,尝试从分层深度强化学习和多智能体强化强化学习等方面进行设计;另外可以尝试突破深度强化学习与实战结合的难点。

作者简介:李俊慧,(1999-),女,山西省吕梁市,北方自动控制技术研究所,硕士研究生,研究方向:无人智能决策。

参考文献

[1] 李理,李旭光,郭凯杰等.国产化环境下基于强化学习的地空协同作战仿真[J].兵工学报,2022,43(S1):74-81.

[2] 王彤,李志,王轶鹏.自主系统与人工智能对美国陆军多域作战的影响分析[J].飞航导弹,2020(05):1-6+9.

[3] 杨思明,单征,丁煜,李刚伟.深度强化学习研究综述[J].计算机工程,2021,47(12):19-29.

[4] 刘春源.基于深度强化学习的路径规划技术研究[D].天津大学,2019.

[5] 魏宁.深度强化学习落地指南[M].北京:电子工业出版社,2021.

[6] 刘希阳. 多无人机协同路径规划方法研究[D].哈尔滨工业大学,2021.

[7] QIE H,SHI D,SHEN T,et al. Joint optimization of multi-UAV target assignment and path planning based on multi-agent reinforcement learning[J]. IEEE Access,2019,7:146264-146272.

[8] 陈昱宏,高飞飞.基于深度强化学习的多目标无人机路径规划[J].无线电通信技术,2022,48(06):957-970.

[9] Zhao X, Zong Q, Tian B, Zhang B, You M. Fast task allocation for heterogeneous unmanned aerial vehicles through reinforcement learning. Aerosp Sci Technol. 2019;92:588–94.

[10] 李波,越凯强,甘志刚,高佩忻.基于MADDPG的多无人机协同任务决策[J].宇航学报,2021,42(06):757-765.、

[11] 胡致远,王征,杨洋,尹洋.改进PPO算法的AUV路径规划研究[J].电光与控制,2022,30(01):87-91+102.

[12] 刘朝阳,穆朝絮,孙长银.深度强化学习算法与应用研究现状综述[J].智能科学与技术学报,2020,2(04):314-326.